NEXUS Magazin: https://www.nexus-magazin.de/artikel/lesen/technogene-erderwaermung-die-rundfunktheorie-des-klimawandels

Technogene Erderwärmung: Die Rundfunktheorie des Klimawandels

Ethan Clark ist aufrichtig um die Erde besorgt, als er für eine Website zum anthropogenen Klimawandel zu recherchieren beginnt. Dabei stößt er auch auf die noch junge CO2-Debatte und fragt sich, wieso gestandene Wissenschaftler vehement der Ansicht widersprechen, die heute Konsens ist. Als er sich näher mit den Argumenten der Kritiker beschäftigt, findet er sie valide – doch der Temperaturanstieg der Erde ist nicht zu leugnen. Was war zum Beispiel zwischen 1925 und 1944 los, als die globalen Temperaturen um 0,37 Grad Celsius hochschossen, aber gar nicht genug CO2 in der Atmosphäre war, um den Anstieg zu erklären?

Ethan Clark ist aufrichtig um die Erde besorgt, als er für eine Website zum anthropogenen Klimawandel zu recherchieren beginnt. Dabei stößt er auch auf die noch junge CO2-Debatte und fragt sich, wieso gestandene Wissenschaftler vehement der Ansicht widersprechen, die heute Konsens ist. Als er sich näher mit den Argumenten der Kritiker beschäftigt, findet er sie valide – doch der Temperaturanstieg der Erde ist nicht zu leugnen. Was war zum Beispiel zwischen 1925 und 1944 los, als die globalen Temperaturen um 0,37 Grad Celsius hochschossen, aber gar nicht genug CO2 in der Atmosphäre war, um den Anstieg zu erklären?

Der Klimawandel ist eines der am stärksten polarisierenden Themen unserer Zeit: Die einen bestreiten seine Existenz und halten alles für eine politische Verschwörung zur Umverteilung von Vermögen, die anderen sehen, wie sich vor ihren Augen das Ökosystem und die Welt in einer nie da gewesenen Geschwindigkeit verändern. Einige sprechen von einem Konsens innerhalb der wissenschaftlichen Gemeinschaft und meinen, den Schuldigen dingfest gemacht zu haben, während andere den Konsens anfechten und überzeugt sind, dass wir in Sachen Klimawandel noch lange nicht alles verstanden haben.

In diesem Artikel stelle ich eine kaum bekannte These vor, die die Lager zusammenbringen könnte: die Broadcast Theory – die Rundfunktheorie des Klimawandels oder auch Theorie des funkinduzierten Klimawandels. Bevor meine Reise in die Rundfunktheorie begann, recherchierte ich zum Einfluss von CO2 auf den Klimawandel, für eine Website, die dazu beitragen soll, Menschen zusammenzubringen, Lösungen zu finden und echte Veränderungen in der Welt zu bewirken. Wie viele Neulinge auf dem Gebiet war ich angetrieben von den Auswirkungen des Klimawandels auf die kommenden Generationen und sah keinen Grund, die bestehenden Theorien anzuzweifeln. Im Laufe meiner Recherchen erfuhr ich aber mehr und mehr von der erbitterten Debatte. Damals steckte der „Konsens“ zum Klimawandel noch in den Kinderschuhen, und mich verblüffte, wie viele Wissenschaftler mit den Informationen zu kämpfen hatten, die sie als Fakten und Beweise präsentiert bekamen. Kein Wunder – schließlich ging es um ein System, das eigentlich zu groß war, um irgendetwas beweisen zu können. Aber ließ sich grundsätzlich leugnen, dass sich unsere Welt schneller veränderte denn je?

Als ich mich eingehender mit diesen Fragen beschäftigte, entdeckte ich, dass einige Argumente, die CO2 im Zusammenhang mit dem Klimawandel eine weniger gewichtige Rolle zuschreiben, zu valide sind, um sie zu ignorieren. Gleichzeitig fragte ich mich aber, was mit unserem komplexen Klimasystem nicht stimmt – schließlich gab es genug offene Fragen. Was war zum Beispiel die Ursache der Erwärmung Anfang des 20. Jahrhunderts, als zwischen 1925 und 1944 die Temperatur um 0,37 Grad Celsius anstieg?1 Selbst manche Wissenschaftler, die dem offiziellen Standpunkt des Weltklimarats (IPCC) grundsätzlich zustimmen, räumen ein, dass es zur damaligen Zeit nicht genug CO2 in der Atmosphäre gab, um ebenjenes als Hauptursache der Klimaveränderungen benennen zu können. Ist es möglich, dass es noch weitere Faktoren gibt, die unsere Atmosphäre beeinflussen und tatsächlich zu den globalen Temperaturanomalien passen?

Diese Frage ließ mich nicht los, und so suchte ich nach einem unvoreingenommenen Ansatz jenseits des Schwarz-Weiß-Denkens der Panikmacher und Klimawandelleugner. Ich wollte die Vor- und Nachteile jeder Theorie, die ich finden konnte, nachvollziehen und eine klare Vorstellung von den tatsächlichen Vorgängen entwickeln. Dabei stieß ich auf etwas Sonderbares: Die Temperaturanomalien der Neuzeit scheinen mit dem Ausbau des globalen Rundfunknetzwerks zu korrelieren.

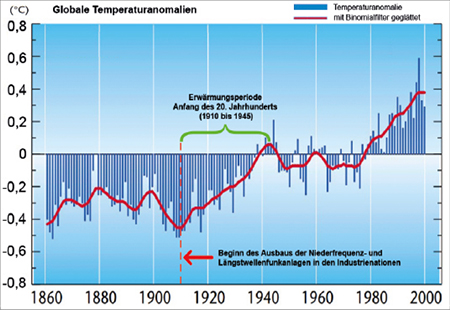

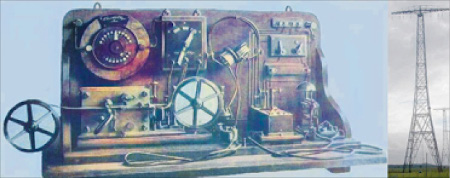

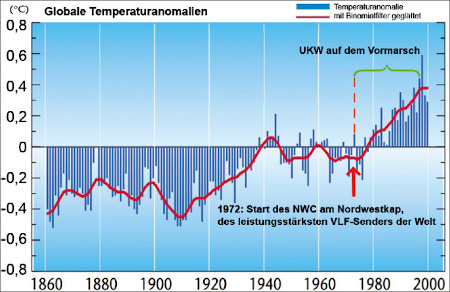

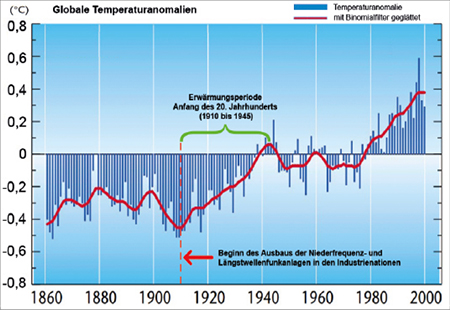

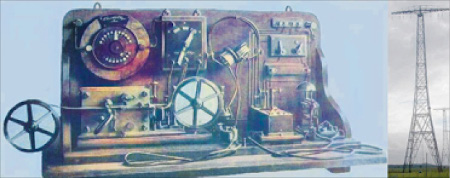

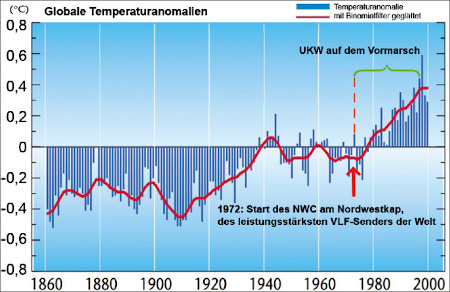

Ein Blick auf die grafische Darstellung der globalen Temperaturanomalien (siehe Abb. 1) von der Weltorganisation für Meteorologie (WMO) zeigt: Das, was wir als globale Erwärmung bezeichnen, begann um 1910 mit der Erwärmungsperiode des frühen 20. Jahrhunderts.2 Zur gleichen Zeit begannen die Industrienationen damit, erste Rundfunksendungen durch den Äther zu schicken und die zugehörigen Netzwerke auszubauen.

Abb. 1: Die globale Erwärmung begann mit der Erwärmungsperiode Anfang des 20. Jahrhunderts, als in den Industrienationen leistungsstarke Rundfunknetze errichtet wurden.

Als im Zuge des Ersten Weltkrieges fast alle Rundfunkgeräte beschlagnahmt wurden, kam der globale Temperaturanstieg zum Stillstand. Mit dem Rundfunkboom der frühen 1920er Jahre setzte der Anstieg wieder ein. Mehr und mehr wurde mir klar, dass sich mit jedem Einschnitt in der Geschichte unserer Rundfunkgewohnheiten auch die globale Temperatur veränderte.

Als ich tiefer in die Materie eintauchte, fand ich heraus, dass es einen physikalischen Mechanismus gibt, über den die von Rundfunksendeanlagen abgestrahlte Energie letztlich dazu führt, dass in der oberen Atmosphäre Ozon abgebaut wird. Die Erklärungen sind in wissenschaftlichen Nischenzeitschriften versteckt, und einige der weltweit führenden Physiker haben bereits darauf hingewiesen und zur allgemeinen Sorge aufgerufen. Nur hat die Öffentlichkeit nichts davon erfahren!

Also begann ich, alles Mögliche zu der kaum bekannten Hypothese des funkinduzierten Ozonabbaus zusammenzutragen – und meine bis heute andauernde Reise in die Rundfunktheorie begann.

Ich möchte nichts weiter, als einer Hypothese Reichweite zu verschaffen, die von Spitzenphysikern aufgestellt wurde, auf deren Forschungsansätze ich mich im Folgenden beziehen werde. Wenn Sie den Artikel zu Ende gelesen haben, stellen Sie sich bestimmt dieselben Fragen wie ich und die zitierten Forscher.

Bevor wir zur eigentlichen Rundfunktheorie und zu der Frage kommen, wie sich unsere Sendetechnologie auf unser Klima ausgewirkt haben könnte, müssen wir den grundlegenden Mechanismus des funkinduzierten Ozonschichtabbaus und seine möglichen Auswirkungen auf die Klimadynamik beleuchten.

TIPER-NOx und der funkinduzierte Abbau der Ozonschicht

Zunächst sollten wir uns vor Augen halten: Seit dem Beginn der regelmäßigen Rundfunkausstrahlungen im Niedrigfrequenz- und Längstwellenbereich um 1910 hat der Rundfunk und die damit verbundenen Frequenzen stetig zugenommen – bis zu dem Punkt, dass wir nicht mehr wissen, was in dem uns umgebenden Strahlungsmeer eigentlich noch natürlich ist.

Im Jahr 2008 wurde im Magazin New Scientist ein Artikel mit dem Titel „Radio waves from Earth clear out space radiation belt“ veröffentlicht. Darin heißt es: Dieselben Längstwellen (VLF) und Langwellen (LW), die zur Kommunikation zwischen U-Booten genutzt werden, dringen auch weit in die Magnetosphäre – das Magnetfeld der Erde – ein und beeinflussen dort eingeschlossene Teilchenpopulationen.3

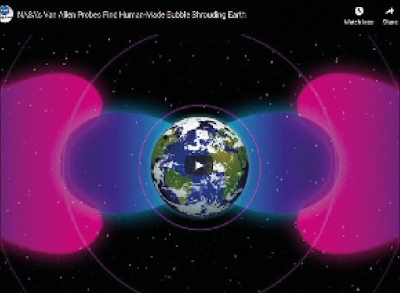

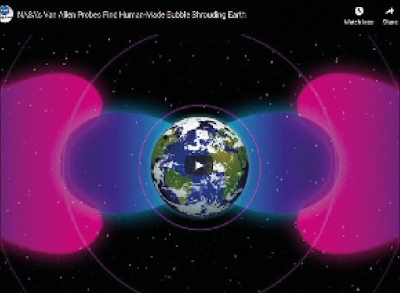

Abb. 2: Die während der VAP-Mission entdeckte künstliche Blase aus Strahlung, die von VLF-Übertragungen erzeugt wird. (© NASA)

Weil diese VLF-Funksender spätestens seit den 1920er Jahren in der Telegraphen- und U-Boot-Kommunikation verwendet werden, so heißt es in dem Artikel weiter, konnten wir die natürlichen Strahlungsgürtel nie in ihrem Urzustand beobachten – die Bestätigung für ihre Existenz erbrachte erst der US-Satellit Explorer 1 im Jahr 1958.

Im Jahr 2012 wurden zwei stark abgeschirmte Robotersonden – die Van Allen Probes (VAP) – gestartet, um den Van-Allen-Strahlungsgürtel zu untersuchen. Dabei handelt es sich um den Strahlungsgürtel, der in Form zweier donutförmiger elektromagnetischer Ringe aus geladenen Teilchen die Erde umgibt. Er wird durch das Magnetfeld des Planeten an Ort und Stelle gehalten. Bei der VAP-Mission kam heraus, dass die Strahlung der erdgebundenen VLF-Sender nicht nur einen Teil der Teilchenpopulation beseitigt, sondern im Grunde eine Blase elektromagnetischer Energie um die Erde herum geschaffen hatte (siehe Abb. 2).

Wissenschaftler wie Dan Baker, Direktor des Labors für Atmosphären- und Weltraumphysik an der University of Colorado, sind der Ansicht, dass der Rand dieser künstlichen Blase fast genau mit der Innenseite des Van-Allen-Gürtels abschließt, und sie vermuten, dass einfallende Sonnenstrahlungsteilchen durch die Längstwellen abgelenkt werden könnten. Satellitendaten zufolge ist der Rand des Strahlungsgürtels heute viel weiter von der Erde entfernt als noch in den 1960er Jahren, als wir weniger VLF-Übertragungen hatten. Dan Baker vermutet, dass sich der Strahlungsgürtel der Erde annähern würde, wenn es keine Längstwellen gäbe. Im Jahr 2017 stellte die NASA per Website und Video die Ergebnisse einer Abhandlung mit dem Titel „Anthropogenes Weltraumwetter“ vor, deren Autoren diese durch Längstwellen verursachte Blase beschreiben.4

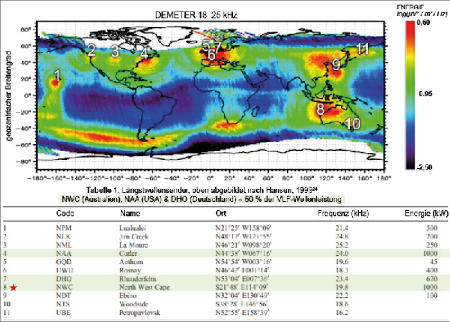

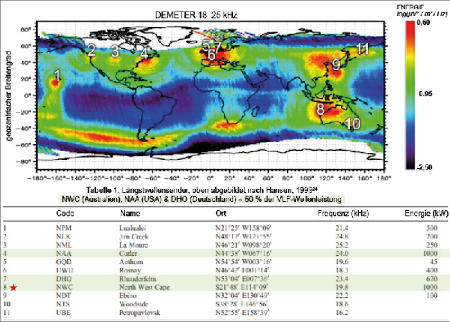

Abb. 3: VLF-Sender mit höherer Leistung, die rund um die Erde verteilt sind. Drei davon machen 50 Prozent der gesamten Längstwellenleistung aus und dominieren die Wechselwirkungen der Wellen und Teilchen in der inneren Magnetosphäre: NWC (Australien), NAA (USA) und DHO (Deutschland).

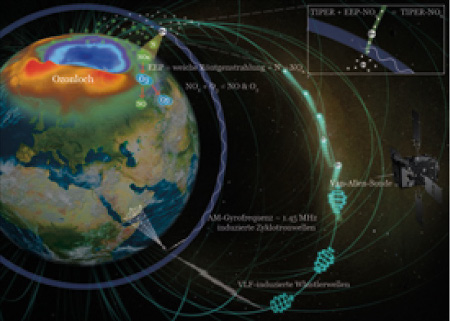

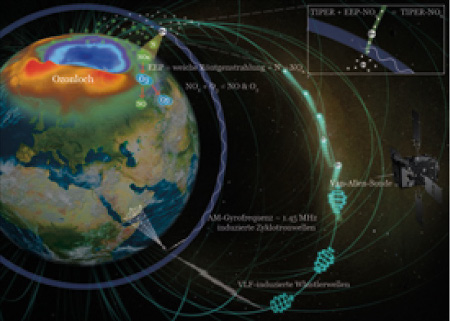

Die künstliche Blase aus VLF-Wellen schirmt aber nicht nur Sonnenstrahlung ab, sondern führt auch dazu, dass sich die in der Magnetosphäre eingeschlossenen Elektronen in die obere Atmosphäre absetzen bzw. niederschlagen. Der Prozess nennt sich TIPER, kurz für Transmitter Induced Precipitation of Electron Radiation oder „funkinduzierter Niederschlag von Elektronenstrahlung“. Diese „Killerelektronen“, wie sie die VLF Group von der Stanford University bezeichnet, können die empfindliche Elektronik von Satelliten beschädigen und ein Gesundheitsrisiko für Astronauten darstellen, die den Strahlungsgürtel und Gebiete mit hohem Elektronenfluss durchqueren.

Schon früh erkannte man, dass VLF-Funkwellen für die Kommunikation über große Entfernungen nützlich sind, da sich solche niederfrequenten Funkwellen horizontal über dem Boden ausbreiten und zwischen der leitfähigen Ionosphäre und der Erde in Zickzackbewegungen auf und ab hüpfen. Normalerweise würde die Ionosphäre die Radiowellen reflektieren und sie somit daran hindern, 5.000 bis 20.000 Kilometer in den Weltraum zu entweichen. Während des Ersten Weltkriegs wurde jedoch entdeckt, dass einige dieser Radiowellen tatsächlich über die Ionosphäre hinaus in die Magnetosphäre vordringen. Diese Radiowellensignale steigen und fallen entlang der Magnetfeldlinien in der Magnetosphäre als diskrete Plasmawellenbündel auf und ab, die als Whistler bezeichnet werden. In der erwähnten NASA-Abhandlung heißt es dazu:

„Eine der ersten beobachteten Auswirkungen des Weltraumwetters auf die Technologie trat während des Ersten Weltkrieges auf, als Funkbeobachter zerstreute Plasmawellen aufzeichneten, sogenannte ‚Whistler‘, die sich durch einen absteigenden Ton im VLF-Radiowellenspektrum auszeichneten und irrtümlich als fallende Bomben identifiziert wurden.“5

Obwohl Radiowellen, die sich in der Atmosphäre ausbreiten, mit zunehmender Entfernung vom Sender schwächer werden und gemäß dem sogenannten Abstandsgesetz von atmosphärischen Molekülen absorbiert werden, trifft dies auf Whistler in magnetosphärischen Wellenleitern nicht zu. Im Gegenteil: Wie es der experimentelle Längstwellensender an der Siple Station in der Antarktis zeigt, werden die VLF-Whistler in vielen Fällen verstärkt, wenn sie mit einer Energie von nur einem Watt durch die Magnetosphäre zur gegenüberliegenden Hemisphäre wandern.

Weltweit gibt es mehr als ein Dutzend dieser leistungsstärkeren Längstwellensender, wobei allein drei von ihnen die Hälfte der gesamten VLF-Wellenleistung abgeben, die die Wechselwirkungen zwischen Wellen und Teilchen in der inneren Magnetosphäre dominiert: NWC in Australien, NAA in den USA und DHO in Deutschland (siehe Abb. 3).

Der leistungsstärkste dieser Hochleistungssender ist die NWC-Sendeanlage am Nordwestkap in der Nähe von Exmouth in Westaustralien mit einer Sendeleistung von 1.000 Kilowatt und einer Frequenz von 19,8 Kilohertz. Sie wurde im Jahr 1972 mit 13 Sendemasten aktiviert. Der größte dieser Masten ist 387 Meter hoch und war viele Jahre lang das höchste von Menschenhand errichtete Bauwerk der südlichen Hemisphäre. Aufgrund der Lage in Äquatornähe und der niedrigen Frequenz verändert diese Sendeanlage stärker als jeder andere VLF-Sender die magnetosphärische Teilchenpopulation.6

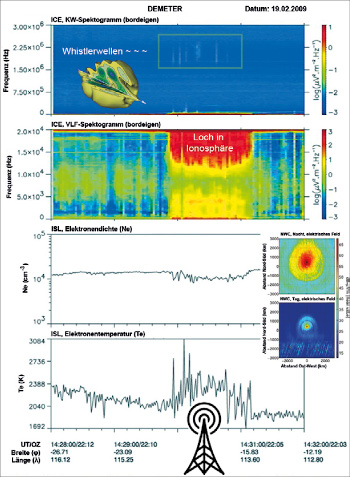

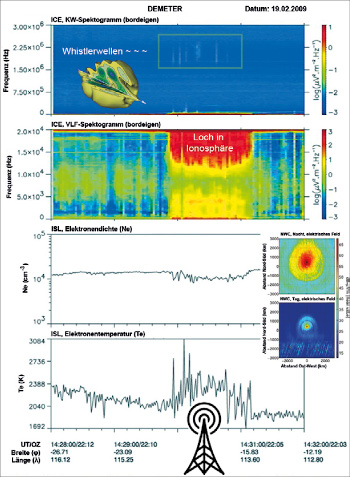

Abb. 4: In der Ionosphäre über den Längstwellensendern bilden sich Löcher, durch die Signale in die obere Atmosphäre entweichen können. Das begünstigt Veränderungen in der dortigen chemischen Zusammensetzung.

Etwa 90 Kilometer über dem NWC-Sender bildet sich in der Ionosphäre eine Art Loch mit 25 Kilometern Durchmesser. Durch dieses können höherfrequente Whistler und Signale von Blitzen und künstlichen Quellen der Erde entkommen – der Sender erzeugt einen Ionosphären-Wellenleiter in die obere Atmosphäre, der Veränderungen in der dortigen Chemie bewirkt (siehe Abb. 4).

Dass hochfrequente Whistler auf diese Weise in die Atmosphäre oberhalb der Hochleistungssender entweichen, ist keine Theorie: In einer Untersuchung konnten Forscher nachweisen, dass aus 16 verschiedenen VLF-Sendestationen insgesamt mehr als 258.000 Watt Sendeleistung in die obere Magnetosphäre abstrahlten.7

In den Feldlinien zwischen dem Nord- und Südpol der Magnetosphäre sind Elektronen gebunden. Normalerweise treffen diese Elektronen auf die Ionosphäre, deren Magnetfeld im rechten Winkel zur Magnetosphäre steht, und werden wieder zurückgestoßen. Die funkinduzierten Whistlerplasmawellen lösen die in der Magnetosphäre eingeschlossenen Elektronen, woraufhin diese die Magnetfeldlinie hinabgleiten und auf die obere Atmosphäre einprasseln. Dieser Elektronenniederschlag (auch Präzipitation energetischer Elektronen) wird kurz als EEP-NOx bezeichnet.

Zusätzlich zu den Whistlern erzeugen Rundfunksender spiralförmige Plasmawellen, die das Magnetfeld der Ionosphäre stören, sodass es nicht mehr senkrecht zur Magnetosphäre steht. Diese herabregnenden energiereichen Elektronen können dann durch die Ionosphäre hindurch und in die obere Atmosphäre gleiten. Dort werden sie abgebremst, was zu weicher Röntgenstrahlung führt, die auch als Bremsstrahlung bezeichnet wird und stark genug ist, um mit stratosphärischem Stickstoff zu reagieren und Stickstoffoxide (NOx) zu bilden.

Diese durch den Elektronenniederschlag gebildeten reaktiven Stickstoffoxide sinken in die Polarwirbel und reagieren mit atmosphärischem Ozon (O3) zu Stickoxid und Sauerstoff. Sie sind deshalb so bedeutsam, weil sich das meiste Ozon in der mittleren Stratosphäre befindet – und genau dort wird am meisten Ozon durch Stickstoffoxide abgebaut.

Obwohl Radiowellen also nicht stark genug sind, um direkt NOx zu bilden oder Ozon abzubauen, erzeugen sie spiralförmige Wellen im ionosphärischen Plasma. Diese führen dazu, dass Elektronen aus der Magnetosphäre in Massen auf die obere Atmosphäre niederschlagen, und diese Elektronen sind energiereich genug, um Stickstoffoxide zu bilden und damit den Ozonhaushalt zu beeinflussen.

Dr. Allison Jaynes referierte für die National Academy of Sciences 2018 über Spitzenforschung zum Strahlungsgürtel. Sie betonte, dass „bei ausreichender Energie“ die Niederschläge von Elektronen die Ozonschicht verändern und sich damit langfristig auf Wetter und Klima auswirken könnten.8

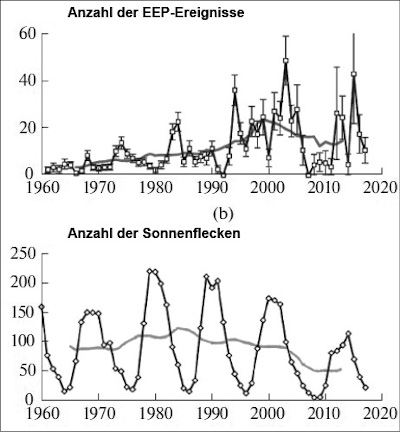

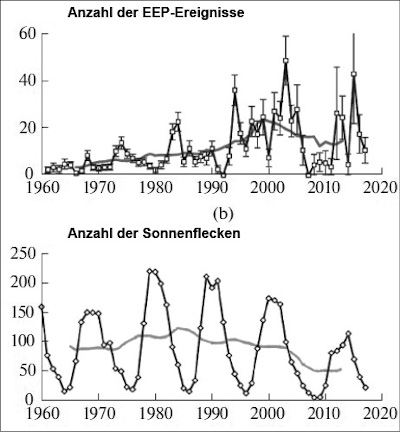

Dr. Jaynes sprach in erster Linie vom EEP-NOx, der durch Sonnenaktivität ausgelöst wird. Im selben Jahr (2018) erschien jedoch eine Forschungsarbeit, in der es hieß, es gäbe einen langfristigen Trend bei diesem energetischen Elektronenniederschlag, der nicht mit der solaren oder geomagnetischen Aktivität übereinstimmt (siehe Abb. 6). Darin wurde auch eingeräumt, dass das Ozon tatsächlich von VLF-Sendern am Boden beeinflusst werden könnte. Die Hypothese vom funkinduzierten Klimawandel ist also nach wie vor nicht widerlegt.9

Im Jahr 2005 fand man mithilfe des Minisatelliten DEMETER heraus, dass der 1.000-Kilowatt-Längstwellensender am australischen Nordwestkap (NWC) den Elektronenfluss im Vergleich mit den Hintergrundwerten um das 3.600-Fache steigert.10 Sieben Jahre später stellte die American Geophysical Union fest, dass derselbe Sender eine enorme Signatur in den ionosphärischen Elektronen hinterlässt, die einen riesigen, hufeisenförmigen Bogen zwischen der Nord- und Südhalbkugel bilden.11

Abb. 5: Transmitterinduzierter Elektronenniederschlag, der über diverse Mechanismen und Stickstoffoxide letztlich zum Abbau von Ozon führt.

Dann wiederum wurde 2008 experimentell beobachtet, dass der NWC-Sender einen etwa 430-mal stärkeren Elektronenniederschlag mittleren Energiegehalts (kurz MEE) erzeugt, als es natürlicherweise zu erwarten wäre. Wie aus neuesten Klimamodellen hervorgeht, wirkt sich das signifikant auf die langfristige Ozonvariabilität aus.12 Ein solcher MEE kann zu einem bis zu 20-prozentigen Abbau des polaren mesosphärischen Ozons führen – wir haben es hier mit Molekülen zu tun, die etwa 90 Prozent der Sonnenstrahlung abwenden, die in unser Klimasystem eindringt!13

Laut Michel Parrot, dem leitenden Wissenschaftler der DEMETER-Mission am französischen Nationalen Zentrum für Weltraumforschung CNES, verursachen VLF-Frequenzen zwischen 10 und 20 kHz, die von Sendern am Boden ausgehen und für die Funknavigation und Kommunikation genutzt werden, ionosphärische Erwärmung, Turbulenzen und Partikelfällung. Ähnliches gelte aber auch für die von Rundfunkstationen verwendeten Kurzwellen, denn auch diese erwärmen die Ionosphäre und können ihre Temperatur und Dichte verändern.14

Parrot bemerkte weiterhin, dass die funkinduzierte Veränderung und Streuung der Plasmawellen in der Ionosphäre an der globalen Erderwärmung beteiligt sein könnte. Der Niederschlag energiereicher Elektronen durch künstliche Wellen könnte auch Blitzentladungen auslösen. Diese gelten als zusätzliche Quelle von Stickstoffoxid (NOx), welches die Ozonkonzentration in der Atmosphäre beeinflusst und dadurch zum Treibhauseffekt beiträgt.

Ozon ist ein empfindliches, aber überaus wichtiges Molekül. Die Reduzierung des stratosphärischen Ozons führt dazu, dass mehr Sonnenenergie tief in das Klimasystem eindringt und von der Oberfläche als langwellige Infrarotstrahlung reflektiert wird. Zusammen mit Treibhausgasen wie CO2, Ozon und von der Meeresoberfläche verdunstetem Wasser erwärmt diese die Oberfläche, das Meerwasser und die Atmosphäre. Ozon besteht aus drei Sauerstoffatomen (O3), die danach streben, mit Elektronen anderer Moleküle zu reagieren, einschließlich ozonabbauender Substanzen (ODS) wie Fluorkohlenwasserstoffen (FCKW). Aus diesem Grund wurde durch ein internationales Umweltabkommen mit dem Montreal-Protokoll beschlossen, die Verwendung von FCKW zu untersagen.

Ozon wird durch solare UV-Strahlung gebildet und reagiert empfindlich auf Stickstoff- und Wasserstoffoxide. Beide Oxide kommen sowohl in der oberen als auch in der unteren Atmosphäre vor, wo bodennahes Ozon entsteht und als Treibhausgas wirkt. Es wird am Äquator photochemisch erzeugt und über zonale Winde und atmosphärische Dynamik zu den Polen transportiert. Die Höhe, in der Ozonmoleküle gebildet und zerstört werden, wird stark von der Elektronegativität der Umgebung beeinflusst, in der diese chemischen Reaktionen stattfinden. Wenn Sendeanlagen den Ionenabfluss stimulieren und die Elektronen- und Ionendichte in polaren Regionen erhöhen, beeinflusst das die Elektronegativität und die hydrodynamischen Prozesse des Ozons werden gestört. Das wiederum verändert die Phasen des O3-Gleichgewichts und beeinträchtigt seine Schutzwirkung.

Abb. 6: Der langfristige Trend beim EEP-NO -Mechanismus, der nicht mit solaren oder geomagnetischen Aktivitäten übereinstimmt, könnte auf VLF-Transmitter zurückgehen.

Die alte Hypothese, dass Ozon nichts mit dem Klimawandel zu tun hat, wurde 2019 mit der Entdeckung einer Rückkopplungsschleife zwischen dem stratosphärischen Ozonverlust und dem Klimawandel in der südlichen Hemisphäre verworfen.15

Obwohl sie das Montreal-Protokoll als Erfolg bezeichneten, sagten Verantwortliche der NASA im Februar 2020, dass der Ozonwert der arktischen Polkappe einen historischen Tiefpunkt erreicht habe, und dass der derzeitige Ozonabbau weitaus dramatischer sei als die letzte große Ozonabbauanomalie in der Arktis im Jahr 2011. Es gibt immer noch Berichte über den Abbau der Ozonschicht in der unteren Stratosphäre über bewohnten Städten, am Äquator sowie in Südafrika und Großbritannien.16

Russische Wissenschaftler vom Institut für Arktis- und Antarktisforschung in Sankt Petersburg haben festgestellt, dass der heißeste Bereich der Klimaerwärmung in der südlichen Hemisphäre mit einem stabilen Maximum des EEP (E > 1 MeV) einhergeht. Sie vermuten, dass diese Partikel in Höhen bis zu 20 bis 40 Kilometer eindringen können – tief genug, um der Atmosphäre Energie zuzuführen, die als regionale Erwärmung zum Vorschein tritt.17

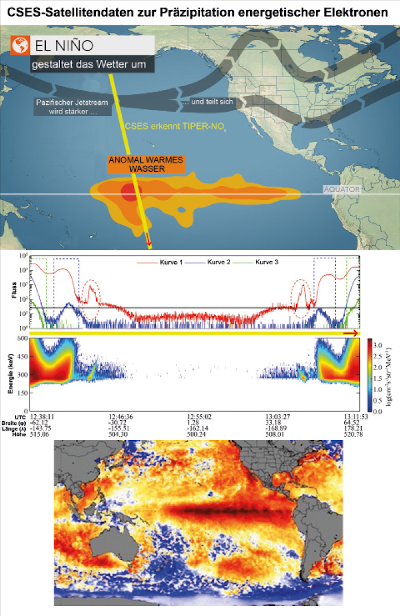

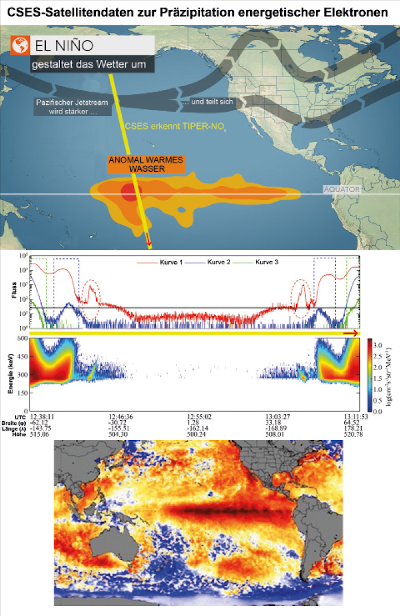

Im Jahr 2018 flog der chinesische Satellit CSES über den zentralen Pazifik und beobachtete ein großes Gebiet mit erhöhtem energetischem Elektronenniederschlag, der durch den australischen NWC-Sender induziert wurde. CSES befand sich über einer Region mit überdurchschnittlich warmem Wasser, das die Südliche El-Niño-Oszillation (ENSO) beeinflusst (siehe Abb. 5). Bei der ENSO handelt es sich um eine unregelmäßig periodische Schwankung der Winde und der Meeresoberflächentemperaturen über dem tropischen östlichen Pazifik, die sich auf die Tropen und das subtropische Klima auswirkt. Wie kürzlich festgestellt wurde, ist ENSO von stratosphärischem Ozon abhängig. Dieses kann durch die Menge an solarer UV-Strahlung, die die Ozonschicht durchdringt und regionale Gebiete der Atmosphäre erwärmt, die zonalen Winde beeinflussen.

Eine weitere Beobachtung des CSES-Satelliten: Die Magnetosphäre übertrug Radiowellen des NWC-Senders auf der Südhalbkugel zu einem korrespondierenden Punkt auf der Nordhalbkugel. Dort schienen die Wellen mit Störstrahlung aus dem chinesischen Stromnetz (Powerline Radiation; PLR) zu reagieren, die ebenfalls Whistler in der Magnetosphäre erzeugt.

Wenn für den NWC-Sender in Australien nachgewiesen ist, dass er im Verhältnis zu den Hintergrundwerten etwa 430-mal mehr Elektronenniederschlag mittleren Energiegehalts produziert, und weitere Forschungen darauf hindeuten, dass der MEE das polare mesosphärische Ozon um etwa 20 Prozent reduzieren kann – sollte man dann nicht in Betracht ziehen, dass der vom NWC-Sender erzeugte MEE auch einen signifikanten Einfluss auf die Ozonvariabilität ausübt – und damit für das erwärmte Gebiet im Ozean direkt unter der MEE-Anomalie verantwortlich ist?

Im Dezember 2019 bildete sich im Pazifischen Ozean vor der Küste Washingtons eine weitere ungewöhnlich große und überdurchschnittlich warme Wasserblase, die erstmals 2013 entdeckt und „Blob“ getauft wurde. In derselben Region wurde sechs Jahre zuvor von Satelliten erhöhter EEP beobachtet, der durch Interaktionen zwischen zwei Längstwellensendern entstanden war. Einer davon stand nördlich von Seattle, der andere auf Hawaii.

Wir können warme Wassermassen in den Ozeanen als völlig natürlich abtun, aber angesichts des komplexen Zusammenspiels von Ozon in der oberen Atmosphäre und dem funkinduzierten Elektronenniederschlag wissen wir im Grunde nicht mehr, was „natürlich“ eigentlich bedeutet.

Wiederherstellung des Strahlengürtels

Die Idee, dass Längstwellensender die chemische Zusammensetzung der oberen Atmosphäre und das Wetter beeinflussen können, ist nicht neu. 1977 stellten Vampola et al. in einer Forschungsarbeit mit dem Titel „VLF transmission induced slot electron precipitation“ die Hypothese auf, dass die Energiezufuhr in die obere Atmosphäre in der Nähe solcher Sender einen messbaren Einfluss auf das Wetter haben könnte.18

Interessanterweise wurde dabei auch festgestellt, dass die Strahlungsgürtel sich vermutlich wieder absenken und zu einer Gefahr für Satelliten werden könnten, wenn wir aufhören würden, Hochleistungslängstwellenstrahlung auszusenden. Die Satelliten könnten beispielsweise aus der Umlaufbahn geworfen werden. Außerdem wurden Vorschläge gemacht, wie wir Längstwellen nutzen könnten, um die Teilchenpopulation im Strahlungsgürtel vorsätzlich zu verändern.

Im Jahr 2017 startete die US-Luftwaffe den DSX-Satelliten an Bord der Rakete SpaceX Heavy Falcon 2. Ziel der Mission war es, einen satellitengestützten VLF-Sender zu testen, mit dem die Teilchenpopulation im Strahlungsgürtel beeinflusst werden sollte. Dies geschah im Rahmen des inzwischen größten Geo-Engineering-Projekts der Welt, das den Namen „Radio Belt Remediation“ (Wiederherstellung des Strahlungsgürtels) trägt. Offiziellen Angaben zufolge soll der bordeigene experimentelle VLF-Sender den Strahlungsgürtel von schädlicher Strahlung befreien und so die Schäden begrenzen, die im Falle eines Atomschlags oder eines natürlichen Strahlungsanstiegs an orbitalen Satelliten entstehen. In diesem Sinne muss der funkinduzierte EEP auch als eine Angelegenheit der nationalen Sicherheit verstanden werden.

Im Dezember 2019 erschien im Magazin Science ein Artikel über die Wiederherstellung des Strahlungsgürtels. Darin hieß es, durch die Experimente könnten große Mengen Stickoxide und Wasserstoffoxide freigesetzt werden – genug, um die stratosphärische Ozonschicht abzutragen. Im Artikel wird die Weltraumphysikern Dr. Allison Jaynes mit den Worten zitiert:„Wir wissen nicht, wie stark die Auswirkungen [auf unsere Atomsphäre] sein könnten.“19

Gegenstand eines anderen, kürzlich erschienenen Artikels ist die Auswirkung des Weltraumwetters auf die Bewohnbarkeit erdähnlicher, exoplanetarer Klimate. Die Autoren zeigen, dass der energetische Elektronenniederschlag Schwankungen des mesosphärischen Ozons von bis zu 34 Prozent herbeiführt und sich langfristig auf das Klima auswirken könnte. Es heißt, der Weltklimarat IPCC habe die potenzielle Bedeutung des energetischen Elektronenniederschlags erkannt und werde die EEP-Ozon-Ionenchemie detailliert in den nächsten Bewertungsbericht im Jahr 2022 aufnehmen.20

Obwohl die globale Bedeutung des energetischen Elektronenniederschlags immer noch ungewiss ist, muss er beachtet werden, wenn wir ein umfassendes Verständnis für unser Klimasystem, auch auf regionaler Ebene, entwickeln wollen. Er gewinnt umso mehr an Bedeutung, wenn er als weitere menschengemachte Auswirkung in unserem gemeinhin als Anthropozän bezeichneten Zeitalter identifiziert werden kann.

Der Mensch erhöht nicht nur die Treibhausgase, sondern beeinflusst, wie uns jetzt bewusst wird, durch den Ozonschichtabbau möglicherweise auch das Ausmaß der solaren UV-Erwärmung dieser Treibhausgase.

Wenn wir die Längstwellenblase und ihre potenzielle Bedeutung nicht als anthropogene Variable in unsere Gleichung des Klimasystems einbeziehen, ist die Gleichung unvollständig. Die Längstwellenblase blockiert anerkanntermaßen solare Teilchen und beeinflusst möglicherweise die Ozonmenge, was es der solaren UV-Strahlung ermöglicht, tiefer in das Klimasystem einzudringen. Wir können es uns nicht leisten, unsere Schlussfolgerungen auf eine unvollständige Gleichung zu stützen. Dies zu tun, wäre unverantwortlich, egal zu welchem Ergebnis wir kommen.

Abb. 7: Der Satellit CSES entdeckte eine Region mit erhöhtem EEP mittleren Energiegehalts über einer anomal warmen Wasserregion im Pazifik, die für Wind- und Meerestemperaturen tropischer und subtropischer Klimate signifikant ist.

Bislang gibt es in der wissenschaftlichen Literatur keine eindeutige Bezeichnung für diesen hypothetischen anthropogenen funkinduzierten Ozonabbaumechanismus, weshalb er in der Diskussion untergeht und das ganze Thema nur schwer nachzuvollziehen ist. Es gibt endlose Forschungsergebnisse zum funkinduzierten Elektronenniederschlag (TIPER), und ebenso endlose Erkenntnisse über den EEP-NOx-Mechanismus (durch Elektronenniederschläge gebildete Stickoxide), der üblicherweise als eine solare Variable betrachtet wird. Aber wie diese beiden Phänomene zusammenspielen, wurde kaum untersucht, obwohl die Hypothese mindestens seit den 1970er Jahren im Raum steht und weiterhin mit innovativen Experimenten zur Wiederherstellung der Strahlungsgürtel erforscht wird.

TIPER-NOx wäre die technische Kombination der beiden Phänomene, und daher werde ich im weiteren Verlauf dieses Artikels den Begriff TIPER-NOx synonym für den funkinduzierten Ozonschichtabbau verwenden. Auch hierbei handelt es sich lediglich um eine Hypothese, aber wenn wir über etwas diskutieren wollen, müssen wir dem Kind einen Namen geben.

Was ist die Rundfunktheorie des Klimawandels?

Bisher haben wir uns direkt mit den Mechanismen des funkinduzierten Ozonschichtabbaus alias TIPER-NOx beschäftigt. Die Rundfunktheorie verknüpft die historische Nutzung der Rundfunkfrequenzen mit der modernen Forschung über die Interaktion dieser Frequenzen mit den ionosphärisch-magnetosphärischen Dynamiken und den globalen Temperaturentwicklungen. Sie soll aufzeigen, wie der Fortschritt der Rundfunktechnologie und TIPER-NOx zur globalen Erwärmung des frühen 20. Jahrhunderts beigetragen haben könnte. Diese Erwärmung begann zeitgleich mit der regelmäßigen globalen Rundfunknutzung im Jahr 1910 und endete mit dem Hungerwinter 1946/47. Möglicherweise gibt es auch einen Zusammenhang des Anstiegs der globalen Temperaturen ab Anfang der 1970er Jahre und der Zunahme des messbaren Hintergrundrauschens durch Rundfunkwellen – beides Trends, die im Jahr 1998 kurzfristig zum Stillstand kamen.

Als das Ultrakurzwellenradio den Mittelwellenrundfunk verdrängte und die weltweite Nutzung der Radartechnologie in den 1970er Jahren stark zunahm, war die Ionosphäre durch eine Vielzahl technischer Frequenzen unterschiedlichen Ursprungs gesättigt. Diese und viele weitere potenzielle Variablen machen es schwierig, Entwicklungen der verwendeten Frequenzen oder Sender mit bestimmten atmosphärischen Entwicklungen oder Klimadynamiken in Verbindung zu bringen. Daher geben die Anfänge des Rundfunks einen einzigartigen Einblick in die Art und Weise, wie diese Frequenzen mit der Ionosphärendynamik interagiert und letztlich über den TIPER-NOx-Mechanismus zum Ozonabbau beigetragen haben könnten. Die Anfänge des Radios übten nicht nur einen maßgeblichen Einfluss auf unser Verständnis der globalen Vernetzung aus, sondern riefen auch die Wissenschaft auf den Plan, mit ausgiebigen Forschungen zu den Eigenschaften der Radiowellenausbreitung und zur Dynamik der Ionosphäre.

Abb. 8: Radiowellen mit der Eigenfrequenz der Ionosphäre erzeugen Plasmawellen, die innerhalb der Ionosphäre spiralförmig entlang der Magnetfeldlinien zu den Polen fließen. Dieser Ionenabfluss kann zum Abbau der Ozonschicht führen.

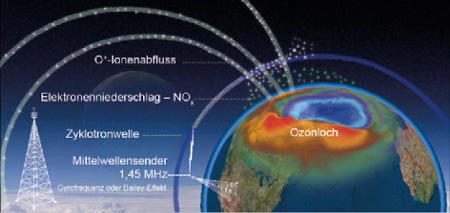

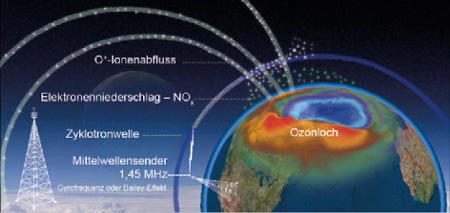

Dass künstlich erzeugte Funkwellen tatsächlich einen Effekt auf die chemische Zusammensetzung der Atmosphäre haben können, wurde mir vor allem durch die Experimente mit der berühmt-berüchtigten HAARP-Anlage bewusst. Diese zeigten, dass spiralförmige Plasma- bzw. Zyklotronwellen entstehen, wenn man die Ionosphäre mit Radiowellen bestimmter Frequenzen beschießt. Diese Plasmawellen bewegen sich entlang der Magnetfeldlinien der Erde in Richtung der Pole, wo sie den Ionenabfluss aus der Ionosphäre verstärken und die Teilchendichte in der Polkappenregion erhöhen.

Eine weitere entscheidende Untersuchung wurde im Jahr 1986 durchgeführt: ein Mutter-Tochter-Raketenexperiment namens MINIX. Dabei wurden nichtlineare Interaktionen zwischen Magnetosphäre und Ionosphäre untersucht und man entdeckte, dass bestimmte Rundfunkfrequenzen ähnliche atmosphärische Effekte hervorrufen wie jene, die bei den Experimenten mit HAARP beobachtet wurden. MINIX zeigte: Es sind vor allem Wellen mit der Eigenfrequenz der Ionosphäre – in 90 Kilometern Höhe sind das rund 1,5 MHz –, die die Bildung von Zyklotronwellen begünstigen. Dies führt zu den geschilderten Effekten, die letztlich die Teilchendichte an den Polen beeinflussen. Diese Frequenz liegt zufällig im Mittelwellenfrequenzband und fällt in den Bereich der sogenannten Gyrofrequenzen (siehe Abb. 8).

Bailey-Effekt und Gyrofrequenzen

Die Gyrofrequenzen umspannen einen Bereich zwischen 630 und 1630 kHz, was sich zufällig mit dem größten Teil des Mittelwellenrundfunkbandes deckt. Die Gyrofrequenz in einem bestimmten Gebiet hängt stark von der geografischen Lage und der Höhe der Ionosphäre ab, sodass Rundfunkanstalten diese normalerweise umgehen, weil ihre Absorption in der Ionosphäre zu schlechtem Signalempfang führt. Doch es gibt Faktoren, die entweder nicht beeinflusst werden können oder unbeachtet bleiben: Geomagnetische Stürme können beispielsweise Schwankungen der Ionosphärenhöhe verursachen, wodurch nahe gelegene Radiostationen in den lokalen Gyrofrequenzbereich geraten. Ebenso können Funkwellen von leistungsstarken Sendern, die ein weites Gebiet abdecken, mit Gyrofrequenzen anderer Regionen kollidieren.

Das Phänomen der Gyrofrequenzen wurde erstmals Mitte der 1930er Jahre von V. A. Bailey erforscht und wurde unter dem Namen „Bailey-Effekt“ bekannt. Der Forscher entdeckte den Effekt bei einer Reihe früher Experimente zur Radioausbreitung mit lokalen Funktürmen. Basierend auf seinen Experimenten stellte Bailey die Vermutung auf, dass es nur ein bis zwei Kilowatt (1.000 bis 2.000 Watt) benötigen würde, um den Effekt zu stimulieren. Mithilfe von Radiowellen würde dabei eine Erwärmung in der Ionosphäre hervorgerufen; zudem würden andere Längstwellensignale, die die erwärmte Region passieren, um das Vier- bis Zehnfache verstärkt werden.

Im Jahr 1946 wurde durch ein Experiment verifiziert, dass dieser Effekt von nur 400 bis 500 Watt verursacht wird. Gegenwärtig ist die Mittelwellenausstrahlung auf 50.000 Watt begrenzt – das ist mehr als das Hundertfache der benötigten Ausgangsleistung, um die beschriebenen nichtlinearen Plasmaeffekte in der Ionosphäre zu stimulieren, die andere lokale Signale um das 400- bis 1.000-Fache vergrößern.

Um besser zu verstehen, wie das MW-Rundfunkband die spezifischen Vorgänge in der oberen Atmosphäre stimulieren könnte, müssen wir darauf zurückschauen, wie diese Frequenzen im Verlauf unserer Rundfunkgeschichte genutzt wurden. Nur so lässt sich abschätzen, ob sich daraus kurz- oder sogar langfristige Auswirkungen auf die Atmosphäre ergeben.

Eine kleine Geschichte des Rundfunks

Alles begann an Heiligabend 1909 mit der ersten regulär ausgestrahlten Radiosendung. Die Pionierarbeit von Geistesgrößen wie Nikola Tesla, Thomas Edison und Marconi ebnete den Weg für zivilisatorischen Fortschritt.

Der erste Sendeturm wurde in San Jose, Kalifornien, von einem Elektriker namens Charles Herrold gebaut. Dieser Sender funktionierte mit Funkenstreckentechnik und wurde „San Jose Calling“ genannt. Später wurde daraus KCBS in San Francisco. Charles Herrold begann mit dem Entwurf von Richtantennen, die er auf vielen Dächern in San Jose montierte, damit sich das Radiosignal in alle Richtungen ausbreiten konnte.

Die ersten experimentellen Antennenentwürfe waren große und komplexe T-Antennen, durch die Raumwellen zwei- bis viermal besser verbreitet werden konnten als durch die vertikalen Antennen, die später in den 1930er Jahren entwickelt wurden. Die Raumwellen ließen allerdings Radiosignale von der Ionosphäre zurückprallen, was übermäßige Interferenzen verursachte und immer wieder zu Problemen führte. Auch in der HAARP-Anlage in Alaska wird übrigens ein flaches Antennendesign verwendet, da die so erzeugten Wellen besser die Ionosphäre durchdringen und dort die oben beschriebenen Plasmawellen und Phänomene erzeugen, wie sie beim EEP-NOx-Prozess auftreten.

Um 1910 begannen die Industrieländer dann damit, leistungsfähige Netze transozeanischer Langwellen-Radiotelegrafiestationen aufzubauen, um mittels Morsezeichen mit anderen Ländern zu kommunizieren (siehe Abb. 9).

Ein Zitat aus einem Artikel über die Geschichte des Rundfunks zeigt, wie viel Energie diese frühen Stationen mithilfe der leistungsstarken Funkenstreckensender erzeugt haben:

„Es wurden riesige Funkenstationen mit enormer Leistung entwickelt, die große Antennen verwendeten. Gemessen an späteren Standards waren diese frühen Stationen viel zu leistungsstark – tatsächlich waren sie so stark, dass ihre Signale wahrscheinlich mehr als einmal um die Welt gingen. Die Empfänger waren jedoch so unsensibel, dass diese Sendegiganten gebraucht wurden, um ein qualitativ hochwertiges Angebot zu gewährleisten.21

Nach dem Untergang der Titanic im Jahr 1912 – und am Ende des Ersten Weltkriegs – begann das US-Militär mit dem Einsatz von Löschfunkensendern und Längstwellenfunkübertragungen (VLF, 3 bis 30 kHz), die von großen Antennenkomplexen an der Küste und zu Sicherheitszwecken auf Schiffen ausgestrahlt wurden.

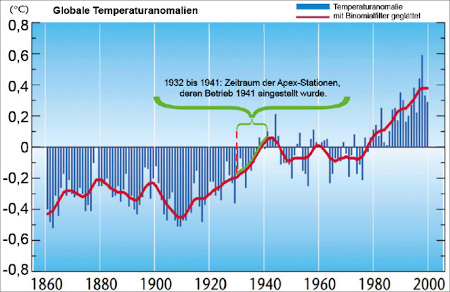

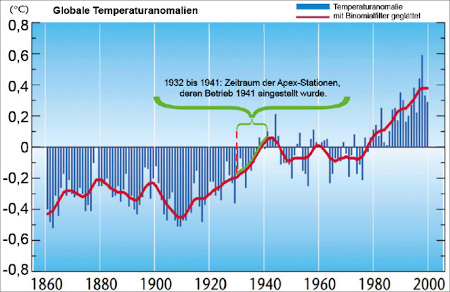

Abb. 9. Links: Kommerzieller Radiotelegrafieempfänger aus dem ersten Jahrzehnt des 20. Jahrhunderts. Rechts: Die Funkstation Grimeton in Südschweden, eine frühe Langwellenstation für drahtlose, transatlantische Telegrafie. Von den 1920er bis in die 1940er Jahre übertrug sie Telegrammverkehr per Morsezeichen nach Nordamerika und in andere Länder.

Die Technologie entwickelte sich weiter, als Amateure zu forschen begannen. Während des Krieges beschlagnahmte die Regierung jedoch alle Sende- und Empfangsgeräte. Die einzige zivile Station, die weiter betrieben werden durfte, war Westinghouse.

Frühe Experimente zeigten auch, dass Längstwellen in Meerwasser eindringen können – eine Tatsache, die von der britischen Royal Navy während des Ersten Weltkrieges ausgenutzt wurde. Durch eine Reihe von Funkverbreitungsexperimenten mit Längstwellenfrequenzen entwickelte das Forschungslabor der US-Marine die Unterwasserkommunikation weiter. Diese Aufrüstungen führten zum heute geltenden Längstwellenkommunikationsnetz der US Navy. Andere Länder folgten diesem Beispiel.

1919 bis 1925: Der Rundfunk boomt

Mit dem Ende des Ersten Weltkriegs und den damit verbundenen Rundfunkbeschränkungen begann der Rundfunkboom der frühen 1920er Jahre. Ab 1920 waren regelmäßig menschliche Stimmen und Musik über den Äther zu hören. Im Jahr 1921 gab es einen regulären Rundfunksender; im März 1923 waren bereits 556 Sender zugelassen. Zwischen 1921 und 1926 breitete sich das Radio explosionsartig aus, wobei der Hauptboom zwischen 1922 und 1925 stattfand. Zeitungen und Kaufhäuser begannen mit Rundfunkwerbung. Die Niederlande, Argentinien und andere Länder folgten dem Beispiel, als sich dieser Trend über die ganze Welt verbreitete.

Mit Beginn der Übertragung stieg die globale Temperatur schneller und höher, wie wir in der Grafik der globalen Temperaturanomalien während der Erwärmungsperiode des frühen 20. Jahrhunderts sehen können. Zwischen 1925 und 1945 gab es einen Temperaturanstieg von 0,37 Grad Celsius (siehe Abb. 10).

Mit der Erforschung höherer Frequenzen wurde ein neues Phänomen entdeckt: Raumwellen. Raumwellensignale prallen von der Ionosphäre zurück und erzeugen über große Entfernungen eine Vielzahl von Interferenzen, die manchmal dazu führen, dass mehr als ein Programm gleichzeitig gehört wird. Die frühe Frequenzsteuerung war schlecht und änderte sich, wenn die Antennen im Wind schwankten. 1923 war klar, dass der Rundfunkdienst grundlegend überholt werden musste.

Der kontinuierliche Ausbau brachte weitere Regulierungen, Vorschriften und Probleme mit sich, mit denen sich die Regierung auseinandersetzen musste. Bis 1925 gab es 536 Anbieter von Rundfunkstationen für schätzungsweise eine halbe Million Radioempfänger. Von diesen Stationen sendeten 200 im Gyrofrequenzbereich, mit ausreichend Leistung (400 bis 500 Watt), um den Bailey-Effekt zu stimulieren.

1925 bis 1945: Experimente und Chaos

1927 überflutete eine Vielzahl neuer Stationen und Frequenzen den Äther, und landesweit war eine Zunahme der Interferenzen zu spüren. Als die Zustände immer chaotischer wurden, schlossen sich Stationen zusammen, um den Äther absichtlich zu stören und so eine neue Regulierungsstruktur zu erzwingen, die von Radiostationen im ganzen Land gefordert wurde.

1928 wurde endlich eine neue Struktur für das Rundfunksystem definiert und die Anzahl der Stationen auf 585 reduziert. Die Reservierung bestimmter Frequenzen für kanadische Kanäle und die sogenannten Clear Channels, die damit ohne Interferenzen von anderen Stationen senden konnten, ermöglichte den Kanalbetreibern eine Nutzung mit einer Leistung von bis zu 50 Kilowatt. Diese Neuzuweisung brachte schließlich Ordnung aus dem Chaos, und fast 70 Jahre später bildet diese historische Festlegung immer noch die Grundlage für das Mittelwellenrundfunkband.

Abb. 10: Mit Beginn des Ersten Weltkriegs wurden fast alle zivilen Rundfunksendungen eingeschränkt – und die globale Temperatur stagnierte. Als die Kriegsrestriktionen endeten und der Rundfunkboom begann, stieg auch die globale Temperatur an.

In den folgenden Jahren halfen uns drei große Rundfunkexperimente dabei, die Grenzen des Möglichen zu erfassen und zu erkennen, wie turbulente ionosphärische Prozesse durch die Rundfunktechnik angeheizt worden sein könnten:

- die Apex-Stationen, auch „Skyscraper Radio“ genannt;

- Amerikas erster „Supersender“ WLW 700 und

- der Aufschwung der UKW-Frequenzmodulation

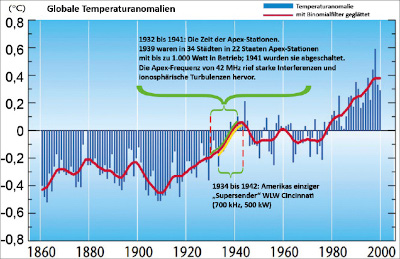

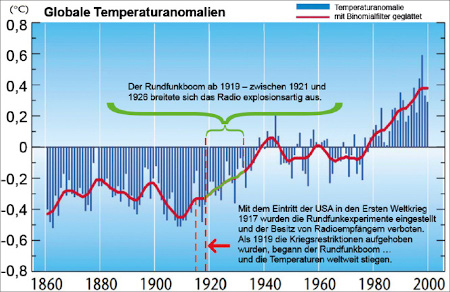

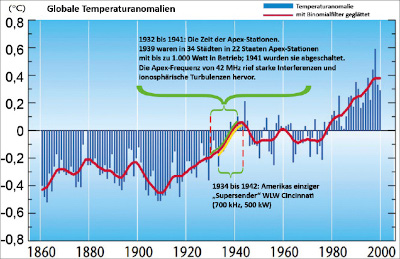

1932 bis 1941: Apex „Skyscraper Radio“ (25 bis 42 MHz)

Die US-Rundfunkbehörde FCC ermutigte die Rundfunkanstalten, mit „Ultrahochfrequenzen“ über 20 MHz zu experimentieren, und ab 1934 wurden regelmäßige Sendungen in New York ausgestrahlt. Im Jahr 1937 beschloss die FCC dann, ein Hochfrequenz-Rundfunkband einzuführen, in dem jeder Kanal die vierfache Bandbreite eines typischen Mittelwellenkanals hatte. Dadurch sollte es weniger Interferenzen geben, und es konnte ein besser klingendes, aber immer noch mittelwellentaugliches Signal erzeugt werden, das einen neuen Maßstab in der praktischen Funktechnologie setzte. Es handelte sich um eine Form der Ultrakurzwelle, die wegen ihrer hohen Frequenzen und Antennenstandorte „Apex“ (dt.: Spitze) genannt wurde.

Bis 1939 gab es in 34 Städten in 22 US-Bundesstaaten Apex-Stationen, die bis zu 1.000 Watt mit Frequenzen von 25 bis 26 MHz und 42 MHz sendeten. In den frühen 1930er Jahren war jedoch nicht viel über die Ausbreitungseigenschaften bei 25 bis 40 MHz bekannt, und wie heutige Funkamateure wissen, variieren die Ausbreitungsbedingungen der von den Apex-Stationen benutzten Frequenzen über den elfjährigen Sonnenfleckenzyklus enorm. Als 1932 die ersten Versuche mit Apex begannen, kam die Sonne gerade aus einem Sonnenfleckenminimum. Daher konnten die neuen Stationen in den ersten Betriebsjahren wahrscheinlich eine weitgehend störungsfreie Abdeckung garantieren. Aber 1936 war ein Höhepunkt der Sonnenfleckenaktivität erreicht, und plötzlich waren die experimentellen Apex-Stationen rund um den Globus zu hören!

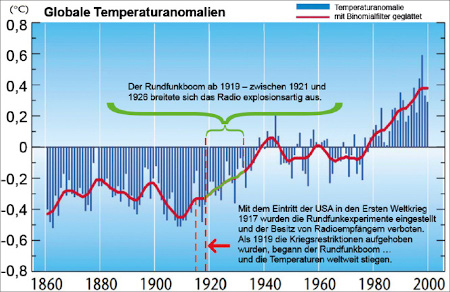

Abb. 11: Für die Apex-Frequenz von 42 MHz wurde festgestellt, dass sie starke Interferenzen und ionosphärische Turbulenzen hervorrief. Als die Ausstrahlung von Apex eingestellt wurde, stoppte der Anstieg der globalen Temperatur.

Das allein erwies sich als großes Problem. Im Jahr 1945 erkannte das US-Kriegsministerium außerdem, dass 42-MHz-Frequenzen besonders starke Interferenzen mit von der Ionosphäre abprallenden Raumwellen hervorrufen.

Mit diesen Problemen und der Entdeckung der Ultrakurzwelle wurden die Apex-Stationen im Jahr 1941 abgeschaltet. Zu dieser Zeit verlangsamte sich der kometenhafte Anstieg der globalen Temperatur (siehe Abb. 11).

Eine Frage der Rundfunktheorie lautet: Könnte es sein, dass durch die Abschaltung der Apex-Stationen die ionosphärischen Turbulenzen und die EEP-NOx-Ozonabbauprozesse der oberen Atmosphäre nicht mehr stimuliert wurden?

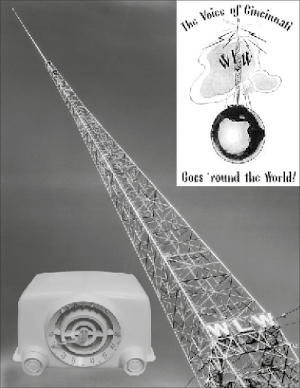

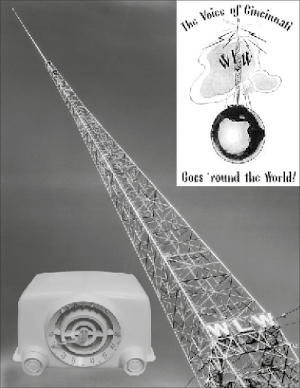

1934: Station WLW 700 – der weltweit erste Mittelwellen-Supersender

Mit welch unglaublicher Sendeleistung die damaligen Stationen sendeten und wie sich das auf die direkte Umgebung auswirkte, zeigt ein Blick auf den Sender WLW 700 Cincinnati. In den 1930er Jahren wurde der Radiosender WLW in Ohio für kurze Zeit zu Amerikas einzigem Mittelwellen-„Supersender“ (siehe Abb. 12).

Abb. 12: In den 1930er Jahren war WLW der einzige Mittelwellen-„Supersender“, weshalb er auch „The Nations Station“ genannt wurde. Er sendete zeitweilig mit 500 kW, was zu seltsamen Anomalien rund um die Sendeanlage führte.

Als Präsident Franklin Roosevelt 1934 einen zeremoniellen Knopf auf seinem Schreibtisch betätigte, rührte sich außerhalb von Cincinnati ein 500.000 Watt (500 kW) mächtiges Ungetüm. Reihen anderthalb Meter langer Glasröhren erwärmten sich und wurden jede Minute von mehr als 2.000 Liter Wasser umflossen. Dutzende Ingenieure zündeten Glühfäden an, legten Schalter um, und innerhalb einer Stunde strömte so viel Energie durch einen 250 Meter hohen Turm, dass man damit eine Stadt mit 100.000 Einwohnern hätte versorgen können. WLW war in der Lage, den größten Teil des Landes zu erreichen.

„Die Menschen, die in der Nähe des Senderstandorts wohnten, hatten oft besseren Empfang, als sie wollten: Einige Lichter ließen sich nicht ausschalten, bis WLW-Ingenieure bei der Neuverkabelung der Häuser halfen. Dachrinnen lösten sich scheppernd von den Gebäuden. Ein Neonhotelschild in der Nähe des Senders wurde nie dunkel. Landwirte erzählten, dass sie WLW über ihre Stacheldrahtzäune hörten.“22

Aufgrund der unglaublichen Leistung, mit der WLW den Äther beherrschte, wurde seine Sendekapazität von 500 kW im Jahr 1939 reduziert und sein Betrieb 1942 schließlich eingestellt.

Die Station WLW 700 arbeitete mit 500.000 Watt im Gyrofrequenzbereich, was, wie bereits erwähnt, die passierenden Längstwellensignale mit nur 400 bis 500 Watt um das Vier- bis Zehnfache verstärken konnte. 500.000 Watt sind das 1.000-Fache der Leistung, die zur Stimulierung des Bailey-Effekts benötigt wird – im Fall eines linearen Zusammenhangs würde das also eine Verstärkung der regionalen Längstwellensignale um das 4.000- bis 10.000-Fache bedeuten.

1973: Der UKW-Boom und der 1.000-Watt-Längstwellensender am Nordwestkap

UKW-Rundfunk benutzt nicht Amplituden-, sondern Frequenzmodulation, die 1933 von Edwin H. Armstrong patentiert wurde. Dadurch konnten das Rauschen sowie atmosphärische Störungen reduziert werden und es wurde weniger Zubehör benötigt.

Abb. 13: Als der UKW-Rundfunk auf dem Vormarsch war und in den 1970er Jahren der leistungsstärkste Längstwellensender der Welt aktiviert wurde, namen Hintergrundrauschen und die globale Temperatur zu.

Obwohl UKW-Rundfunk in den 1940er Jahren entwickelt wurde, dauerte es lange, bis er von der Mehrheit der Radiohörer angenommen wurde. Zu Beginn wurde das Frequenzband vor allem für die Ausstrahlung klassischer Musik in städtischen Gebieten und für Bildungsprogramme verwendet. In den späten 1960er Jahren hatten die Fans des Alternative Rock UKW für sich entdeckt. Der Aufstieg von Stars wie Buddy Holly und vielen anderen läutete eine neue Ära der Rockmusik ein. Erst Mitte der 1970er Jahre wurde UKW zum Mainstream und überholte den Mittelwellenrundfunk (siehe Abb. 13).

Vor dem Siegeszug des UKW-Rundfunks wurde im Jahr 1972 der Längstwellensender NWC in Australien aktiviert. Dabei handelt es sich um den VLF-Sender mit dem höchsten Einfluss auf die Aktivität magnetosphärischer Partikel. Als er eingeschaltet wurde, war auch ein plötzlicher Anstieg des Hintergrundrauschensundder globalen Temperatur zu beobachten.

„Im Rahmen einer anderen weltraumbasierten Radiofrequenzstudie bei 1,0 bis 5,6 MHz und Messungen in einer Höhe von 100.000 bis 120.000 Kilometern über der Erde wurden zwischen 1973 und 1988 Hinweise auf einen zunehmenden anthropogenen, terrestrischen Funkhintergrund gefunden. In unserem Fall haben wir über den Untersuchungszeitraum von November 1997 bis Dezember 1999 [also 1998, Anm. d. Autors] keine statistisch signifikanten Veränderungen festgestellt.“23

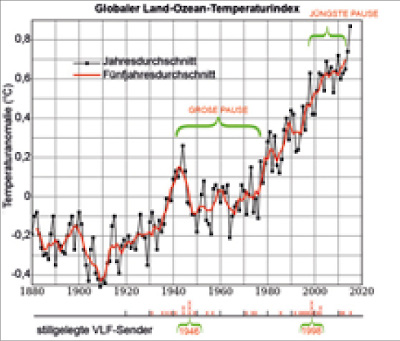

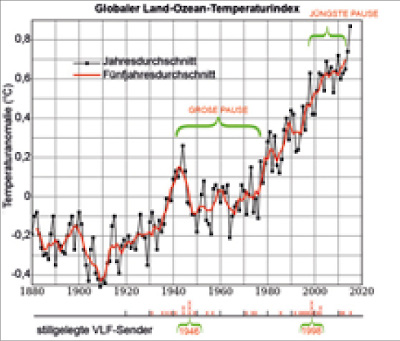

Wenn Sie ein Histogramm der stillgelegten Längstwellensender erstellen, werden Ihnen zwei Jahre auffallen, in denen überdurchschnittlich viele VLF-Hochleistungssender ausgeschaltet wurden: 1946 und 1998. In beiden Jahren war auch ein signifikanter Rückgang der globalen Temperaturen zu beobachten. Der Hungerwinter 1946/47 galt als der kälteste Winter seit 50 Jahren. Das Jahr 1998 wurde von einigen als Beginn einer „Pause der globalen Erwärmung“ bezeichnet, was als bedeutender Wendepunkt im Diskurs über die globale Erwärmung angesehen wird (siehe Abb. 14).

Im CO2-Modell des Klimawandels wird davon ausgegangen, dass wir uns in einem aus dem Ruder gelaufenen Erwärmungstrend befinden, was nachweislich nicht stimmt: Obwohl der CO2-Ausstoß kontinuierlich zugenommen hat, gingen die Temperaturen an bestimmten Punkten der jüngeren Geschichte zurück und stiegen für längere Zeiträume nicht weiter an. Einige der Daten, die uns in der Öffentlichkeit präsentiert werden, berücksichtigen diese Pausen nicht adäquat, nähren aber weiterhin grundlegende Annahmen zum Klimawandel, die möglicherweise nicht stimmen. Achten Sie also darauf, welche Quellen Sie zurate ziehen, und wählen Sie mit Bedacht. Der Klimawandel ist vielleicht weniger schlimm als wir annehmen, doch selbst wenn nur regionale Mikroklimata anthropogen verändert werden, leiden die Menschen, die dort leben, unter den Folgen.

Abb. 14: 1946 und 1998 – In den zwei Jahren mit der umfangreichsten Stilllegung von Längstwellensendern kam es zu einer Unterbrechung des globalen Temperaturanstiegs.

Könnte es sein, dass der Anstieg der Ultrakurz- und Längstwellenfrequenzen in den 1970er Jahren dazu führte, dass diese Frequenzen die Ionosphäre durchdrangen und damit den Abbau der Ozonschicht in der oberen Atmosphäre und den darauf folgenden Anstieg der globalen Temperaturen weiter vorantrieben? Und ist es möglich, dass die Stilllegung von Längstwellensendern im Jahr 1998 den funkinduzierten Ozonschichtabbau und seine Auswirkungen auf das Klimasystem zum Stillstand gebracht hat?

Zusammenfassung, Korrelationen und Fragen zur Rundfunktheorie

Die geschilderten Experimente und Innovationen sind Beispiele für dynamische Veränderungen in unserer sich entwickelnden Nutzung der Rundfunktechnologie. In den frühen Jahren des Rundfunks waren unsere Ätherwellen nicht annähernd so gesättigt mit höheren Frequenzen wie heute. Die Bemühungen der FCC hinsichtlich der Neuzuweisung von Bandbreiten, um der steigenden Nachfrage und Frequenznutzung gerecht zu werden, die Abschaltung der Apexstationen und des WLW-Supersenders in Kombination mit der Erfindung der Ultrakurzwelle, des Fernsehens und der Außerbetriebnahme von Längstwellensendern in den 1940er Jahren führten zum größten Wandel der Nutzung der Rundfunktechnologie seit ihrer Einführung um 1910.

Fassen wir die wichtigsten Argumente zusammen. Die Rundfunktheorie behauptet:

- Einige, wenn nicht alle, zumindest aber die leistungsstärksten Rundfunksender, die im VLF-Bereich oder im Mittelwellenbereich in der Nähe der Gyrofrequenzen senden, erzeugen Plasmawellen in der oberen Atmosphäre.

- Diverse Prozesse führen dazu, dass diese Plasmawellen in die Polregionen wandern.

- Dort lösen sie Elektronen aus der Magnetosphäre, die in die Polarwirbel hinabregnen – ein Prozess, der sich TIPER nennt.

- Dieser Prozess erhöht möglicherweise die Bildung von Stickstoffoxiden durch funkinduzierten Elektronenniederschlag (EEP- bzw. TIPER-NOx).

- Die zusätzlich freigesetzten Stickstoffoxide reagieren mit dem Ozon in der Stratosphäre und zersetzen es.

- Durch den Ozonabbau gelangt mehr Sonnenstrahlung ins Klimasystem, was einen Erwärmungstrend zur Folge hat.

Die Frage, die sich aus der Rundfunktheorie ergibt, lautet also: Standen die Änderungen unserer Rundfunknutzung in Verbindung mit der bekannten Hypothese des funkinduzierten Ozonschichtabbaus, und wirkte sich das auf die Erwärmungsperiode des frühen 20. Jahrhunderts aus, die mit Beginn des Hungerwinters 1946/47 abrupt stoppte (siehe Abb. 15)?

Wenn der funkinduzierte Ozonabbau in den 1940er Jahren zurückgegangen ist, hat sich die Ozonschicht vielleicht wieder erholt. Eine dickere stratosphärische Ozonschicht könnte verhindert haben, dass mehr Sonnenstrahlung in das Klimasystem eindrang, und mit weniger Sonnenstrahlung durchlief das Klimasystem eine fünf Jahre andauernde Abkühlungsphase.

Letztlich geht es hier also nicht nur um den Abbau der Ozonschicht, sondern um einen Prozess, der Auswirkungen auf langfristige Temperaturentwicklungen in Form von sowohl Zu- als auch Abnahmen in beiden Hemisphären haben kann. Diese regionale Dynamik schlägt sich in einem globalen Effekt nieder, da in den USA, Europa, Australien und anderen Teilen der Welt ähnliche Sender verwendet werden.

Die Längstwellen haben nachweislich eine Blase um den Planeten gebildet, die nicht nur den Ozonschichtabbau stimulieren könnte, sondern laut NASA auch in der Lage ist, die Sonnenstrahlung von der Erde abzublocken. Wissenschaftler bezeichnen diese Blase als „undurchdringliche Barriere“ und versuchen immer noch, die dynamischen Prozesse in der oberen Atmosphäre zu verstehen.

Abb. 15: Der Anstieg in der globalen Erwärmung stoppte abrupt, als die Apex-Stationen und der „Supersender“ WLW Cincinnati abgeschaltet wurden.

Während geomagnetischer Stürme dringen Kurzwellenfunk und Frequenzen nahe der lokalen Gyrofrequenz im MW-Rundfunkband sowie Blitzsignale durch Löcher in der Ionosphäre, die über VLF-Senderstandorten entstehen. Dort regen sie möglicherweise den funkinduzierten Ozonabbau an, in einem anthropogenen Verstärkungsprozess, der sich im Rauschen natürlicher geomagnetischer Stürme verliert. Wenn dies zutrifft, könnten wir Mittelwellenkanäle auf und in der Nähe ihrer lokalen Gyrofrequenzen begrenzen oder gar verbieten – nicht nur aufgrund der Empfangsqualität und Interferenzen, sondern auch wegen ihrer möglichen Auswirkungen auf die Umwelt.

Viele Kritiker beschuldigen den vermeintlichen Bösewicht HAARP, aber wir müssen uns darüber bewusst werden, dass die Längstwellensender, im Gegensatz zu den Experimenten, die ab 1993 gelegentlich mit HAARP durchgeführt wurden, durchgehend und fast ununterbrochen seit den 1920er Jahren in Betrieb sind! Die HAARP-Anlage ist zwar leistungsstark, aber nur ein Tropfen auf den heißen Stein, wenn man die Gesamtleistung der vom Menschen erzeugten Hochfrequenzstrahlung in der Atmosphäre betrachtet. Bevor wir also mit dem Finger auf eine oder ein paar wissenschaftliche Anlagen zeigen, sollten wir vielleicht vor der eigenen Türe kehren. Ich will damit HAARP nicht als unbedenklich hinstellen, aber wenn wir uns mit den langfristigen Klimaauswirkungen durch Rundfunksender befassen, müssen wir unsere Aufmerksamkeit auf Sender richten, die kontinuierlich eingeschaltet sind, und die Entwicklung ihrer Nutzung berücksichtigen.

Ich weiß nicht, wie bedeutsam der Rundfunk für das Klimasystem sein mag – aber es liegen jede Menge Indizien vor, die eine Betrachtung wert sind, zumal einige der international führenden Physiker darauf hinweisen, dass wir ernsthaft besorgt sein sollten. Der physikalische Mechanismus, über den Rundfunksender den Ozonabbau stimulieren könnten, ist vorhanden, genauso wie der Input. Vergessen wir auch nicht, dass wir unsere Sendetechnologie stets weiterentwickeln und diese neuerdings um Mobilfunk- und 5G-Sendeanlagen erweitert haben. Vielleicht ermahnt uns die Geschichte und die Rundfunktheorie dazu, vorsichtiger mit der Energie umzugehen, die wir in den globalen elektrischen Schaltkreis der Erde einspeisen – denn auch das kann nachteilige Wirkungen auf unser Klima und unsere Umwelt haben.

Insofern: Herzlich willkommen in der Rundfunktheorie des Klimawandels, einer hochauflösenden Analyse der globalen Temperaturentwicklung und des funkinduzierten Ozonschichtabbaus im Kontext der Geschichte unserer Rundfunktechnologie. Vielleicht werden wir eines Tages auf diese Zeit des Klimakampfes zurückblicken und erkennen, wie sich die Beharrlichkeit, die Welt um uns herum verstehen zu wollen, schließlich ausgezahlt hat. Nicht nur könnten wir unser Klima weitmöglichst stabilisieren, sondern dieses Verständnis dazu nutzen, andere Welten bewohnbar zu machen.

Endnoten

- Egorova, T. A. et al.: „Contributions of Natural and Anthropogenic Forcing Agents to the Early 20th Century Warming“ inFrontiers in Earth Science 6, 27.11.2018; https://tinyurl.com/yb7tgmte

- Die zur Argumentation herangezogene Grafik stammt aus einem von der WMO herausgegebenen PDF. Siehe: „WMO Statement on the Status of the Global Climate in 1999“, WMO-No. 913; https://tinyurl.com/y9pprk6x

- Hecht, J.: „Radio waves from Earth clear out space radiation belt“,NewScientist, 09.06.2008; https://tinyurl.com/yacfnjju

- NASA: „NASA’s Van Allen Probes Spot Man-Made Barrier Shrouding Earth“, 17.05.2017; https://tinyurl.com/ycbdlbbo

- Gombosi, T. I., Baker, D. N., Balogh, A. et al.: „Anthropogenic Space Weather“, 2017.

- Onishi, T., Parrot, M. und Berthelier, J.-J.: „The DEMETER mission, recent investigationson ionospheric effects associated with man-made activities and seismic phenomena“, Comptes RendusPhysique, Elsevier Masson, 2011, 12(2):160–170

- Cohen, M. B. und Inan, U. S.: „Terrestrial VLF transmitter injection into the magnetosphere“ inJournal of Geophysical Research117, 2012; https://tinyurl.com/y9xplhea

- The National Academies: „Cutting Edge of Radiation Belt Research“, Vimeo; https://tinyurl.com/y896le42

- Bazilevskaya, G. A. et al.: „Long-Term Evolution of the Occurrence Rate of Magnetospheric Electron Precipitation into the Earth‘s Atmosphere“ inBulletin of the Russian Academy of Sciences: Physics, Mai 2019, 83(5):584–587

- Gamble, R. J. et al.: „Radiation Belt Precipitation due to Manmade VLF Transmissions: Satellite Observations“, University of Otago, Slideplayer; https://tinyurl.com/yd6fvaps

- American Geophysical Union: „Fall Meeting 2012: Particle Acceleration, Transport, and Loss in the Radiation Belts“, YouTube, 07.12.2012; https://tinyurl.com/y9a7qx2a

- Gamble, R. J. et al.: „Radiation belt electron precipitation by man-made VLF transmissions“ inJournal of Geophysical Research: Space Physics, 21.10.2008, 113(A10); https://tinyurl.com/yddkwx2g

- Andersson, M. E., Verronen, P. T., Marsh, D. R. et al.: „Polar ozone response to energetic particle precipitation over1decadal time scales: the role of medium-energy electrons“ inJournal of Geophysical Research: Atmospheres, 2018, 123(1):607–622

- Parrot, M.: „The Micro-Satellite Demeter“, Laboratoire de Physique et Chimie de l’Environnement et de l’Espace; https://tinyurl.com/yb85kjje

- Harvey, C.: „Shrinking Ozone Hole, Climate Change Are Causing Atmospheric “Tug-of-War”: The Southern Hemisphere jet stream is shifting, bringing more rain to some spots and less to others“, Scientific American, E&E News, 26.03.2020; https://tinyurl.com/r7ue8sc

- Rensselaer Polytechnic Institute: „Damage to the ozone layer and climate change forming feedback loop: New report finds that impacts of ozone-driven climate change span the ecosystem“, ScienceDaily, 24.06.2019; https://tinyurl.com/yydsnj5x

- Shirochkov, A. V. und Makarova, L. N.: „Peculiarities of Long-Term Trends of Surface Temperature in Antarctica and Their Possible Connections with Outer Belt Electron Precipitation“, Workshop im geophysikalischen Observatorium Sodankylä, Finnland, 04.–08.09.06, Abstract; https://tinyurl.com/ybxwqdcz

- Vampola, A. L. et al.: „VLF transmission induced slot electron precipitation“, 05.12.1977; https://tinyurl.com/y8d9hsyk

- Stone, R.: „ U.S. military tests radiation belt cleanup in space: Radio waves could sweep belts clean of satellite-killing particles after nuclear sneak attack“, ScienceMag, 03.01.2020; https://tinyurl.com/y7rkn8bx

- Airapetian, V. et al.: „Impact of Space Weather on Climate and Habitability of Terrestrial Type Exoplanets“ inInternational Journal of Astrobiology, August 2019; https://tinyurl.com/yaa4q94y

- White, T. H.: „Building the Broadcast Band“, Old Radio, 12.02.2004; https://tinyurl.com/y7lcmobv

- June-Friesen, K.: „For a Brief Time in the 1930s, Radio Station WLW in Ohio Became America’s One and Only ‚Super Station‘“ inHumanities,Mai 2015, 36(3); https://tinyurl.com/yaox4tv5

- Burr, T., Jacobson, A. und Mielke, A.: „A global radio frequency noise survey as observed by the FORTE satellite at 800 km altitude“ inRadio Science, 2004, 39(4005); https://tinyurl.com/y9cht2gb

- Hansen, P.: „High power very low frequency/low frequency transmitting antennas“, IEEE Conference on Military Communications, 30.09.-03.10.99; https://tinyurl.com/y53pvyb4

Kommentare

Kommentar von ms (03. März 2024, 21:59 Uhr)

wie passen die mobilfunk-netze ins bild ?

Kommentar von Redaktion (04. März 2024, 09:58 Uhr)

Das ist der noch nicht geschriebene Teil des Artikels. Ethan meinte auf Nachfrage, er hätte bis dato (2020) nichts Offizielles dazu gefunden - aber wir haben hier erst gestern wieder über die These nachgedacht. Ein Planet, getränkt in hochfrequente künstliche Strahlung, Mikrowellenfrequenzen und verdampfendes Wasser, eine globale Industrie, für die das der PR-Supergau wäre ... wer dazu Interessantes und Haltbares beizutragen hat, gern her damit!

Kommentar von Redaktion (04. März 2024, 10:07 Uhr)

Hier z.B. ein Rechercheansatz aus dem Mainstream:

www.weltderphysik.de/thema/hinter-den-dingen/mikrowellenherd

Und hier einer aus der alternativen Presse:

www.qs-wob.de/app/download/5810119836/Mikrowellen+und+HAARP.pdf

Kommentar von Michael (07. März 2024, 13:03 Uhr)

Oh mein Gott!

Schon wieder ein neue Quatsch den Menschen gemachten Klimawandel durch CO2 wegzuerklären. Noch mal, es gibt keinen begründeten Zweifel mehr, dass der Temperaturenanstieg durch die Klimagasemissionen und ihren Auswirkungen verursacht werden.

Kommentar von Christoph (07. März 2024, 17:44 Uhr)

@Michael

Aus welchem Fachbereich kommst du?

Kommentar von Keine Sorge, ... (10. März 2024, 15:43 Uhr)

Es ist wahrscheinlich schlimmer als es aussieht. Nur weil die Evidenz zu Klimagasen und Erderwärmung stichhaltig ist, heißt das nicht, dass die Rundfunktheorie falsch sein muss und vice versa. Es kommt eben alles zusammen. Flächenversiegelung und andere Zivilisationsgeschenke inbegriffen. Der moderne Mensch kennt viele Wege, die natürlichen, regulierenden Prozesse des Planeten zu stören und ist dabei deutlich schneller unterwegs als die Natur selbst.

Kommentar von Drusius (03. April 2024, 12:27 Uhr)

Wenn es eine globale Macht geben sollte, so werden wir globalen Ideologien begegnen, die da sein könnten Pandemien, Klima, globale Veränderungen. Das würde in dem Fall globalen Zielen dienen und würde auf der anderen Seite eine globale Entwicklung des Bewußtseins bewirken. Übrigens steigt die Strahlungsenergie der Sonne seit 1992 an, wenn man glauben will, was man lesen kann. Das wird über eine Ideologie zur materiellen Auswertung benutzt.

Kommentar von Drusius (04. April 2024, 22:02 Uhr)

Vielleicht sollte man noch hinzufügen, das die äußeren Planeten unseres Sonnensystems sich schneller erwärmen, als die Inneren. Soweit zur technogenen Erderwärmung. Schaut einfach nach.

Kommentar von Drusius (04. April 2024, 22:10 Uhr)

Der Apparat, der dahinter steht dürfte sich Sonne nennen und die hatte vor zwei Tagen den höchsten Strahlungsausbruch, dort spielt die Musik, nicht auf den Handys..

Kommentar von Drusius (05. April 2024, 08:23 Uhr)

Erwähnenswert ist vielleicht noch, das einige Wissenschaftler der Meinung sind, das unser Sonnensystem in ein Plasmafeld eingetaucht ist (das wir über 4000 Jahre lang durchqueren) und das auch zur Planetenerwärmung beiträgt.

Geozentrische Erklärungen hatten wir bis zu Galileo Galilei oder Kepler, danach sollte einiges passiert sein, aber wohl in die falsche Richtung, könnte man meinen..

Diese Website verwendet Cookies von Google Analytics, sofern Sie zustimmen.

Weitere Informationen finden Sie in unserer

Datenschutzerklärung.

Ethan Clark ist aufrichtig um die Erde besorgt, als er für eine Website zum anthropogenen Klimawandel zu recherchieren beginnt. Dabei stößt er auch auf die noch junge CO2-Debatte und fragt sich, wieso gestandene Wissenschaftler vehement der Ansicht widersprechen, die heute Konsens ist. Als er sich näher mit den Argumenten der Kritiker beschäftigt, findet er sie valide – doch der Temperaturanstieg der Erde ist nicht zu leugnen. Was war zum Beispiel zwischen 1925 und 1944 los, als die globalen Temperaturen um 0,37 Grad Celsius hochschossen, aber gar nicht genug CO2 in der Atmosphäre war, um den Anstieg zu erklären?

Ethan Clark ist aufrichtig um die Erde besorgt, als er für eine Website zum anthropogenen Klimawandel zu recherchieren beginnt. Dabei stößt er auch auf die noch junge CO2-Debatte und fragt sich, wieso gestandene Wissenschaftler vehement der Ansicht widersprechen, die heute Konsens ist. Als er sich näher mit den Argumenten der Kritiker beschäftigt, findet er sie valide – doch der Temperaturanstieg der Erde ist nicht zu leugnen. Was war zum Beispiel zwischen 1925 und 1944 los, als die globalen Temperaturen um 0,37 Grad Celsius hochschossen, aber gar nicht genug CO2 in der Atmosphäre war, um den Anstieg zu erklären?